Llama 4 Open Source : le nouveau challenger

L’intelligence artificielle vient de franchir une nouvelle étape avec LLaMA 4 Open Source, la toute dernière génération de modèles de langage ouverte développée par Meta. Annoncée début avril 2025, cette version propulse encore plus loin les capacités des IA open source et fait trembler la concurrence des modèles propriétaires comme GPT-4. Quels sont les nouveaux apports de LLaMA 4 par rapport à ses prédécesseurs ? Comment se positionne-t-il face à GPT-4 et aux autres modèles du marché ? Et avec quelles conséquences pour l’écosystème de l’IA, entre monde open source et solutions propriétaires ? Décryptage complet de cette nouvelle IA signée Meta qui allie accessibilité open source et avancées technologiques de pointe.

Dernières actualités : sortie de LLaMA 4 et innovations annoncées

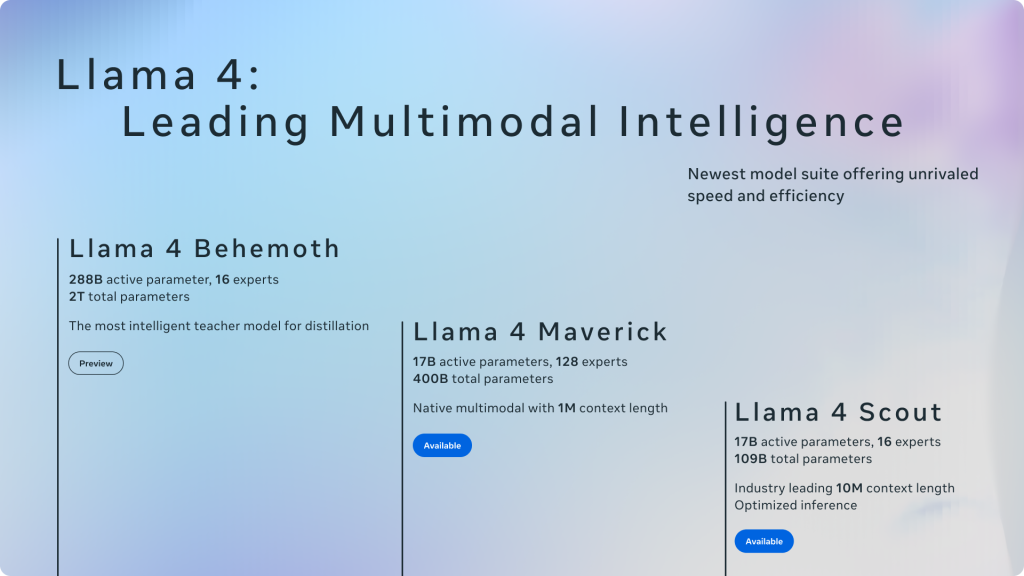

Meta a officialisé la sortie de LLaMA 4 lors d’une annonce début avril 2025, en dévoilant une suite de trois nouveaux modèles au sein de cette famille. Deux modèles sont disponibles dès à présent, tandis qu’un troisième, encore en cours de finalisation, a été présenté en avant-première :

- LLaMA 4 Scout – Un modèle compact pensé pour être déployé sur un seul GPU haute performance (NVIDIA H100). Malgré sa taille réduite, Scout se veut polyvalent et efficace, au point d’alimenter déjà l’assistant virtuel Meta AI sur le web et les applications Messenger, WhatsApp ou Instagram.

- LLaMA 4 Maverick – Un modèle plus imposant, décrit comme un « multimodal natif » de haut niveau. Maverick est conçu pour rivaliser avec les meilleurs modèles fermés du moment en termes de compréhension et de raisonnement. Meta le positionne comme un modèle de référence, plus proche des performances d’un GPT-4 avancé ou des nouveaux modèles Google Gemini.

- LLaMA 4 Behemoth – Un modèle géant annoncé en pré-version (preview), destiné à devenir le plus puissant de la suite. Behemoth sert de modèle enseignant pour entraîner et améliorer les deux autres. Avec des dimensions hors normes (plusieurs centaines de milliards de paramètres actifs), Meta indique qu’il surpasse déjà les versions améliorées de GPT-4 dans certains tests, bien qu’il ne soit pas encore mis à disposition du public.

Les LLaMA 4 Scout et Maverick sont d’ores et déjà disponibles en téléchargement pour les développeurs, que ce soit via le site officiel llama.com ou sur la plateforme Hugging Face. Il est également possible de les essayer directement à travers les services grand public de Meta (WhatsApp, Messenger, Instagram) intégrant désormais ces IA. En outre, Meta a annoncé un événement LlamaCon le 29 avril prochain, dédié aux développeurs, pour partager davantage de détails techniques et sa feuille de route autour de LLaMA 4.

Qu’apporte LLaMA 4 par rapport aux versions précédentes ?

La précédente génération LLaMA 2 (sortie mi-2023) avait marqué les esprits en ouvrant le code d’un modèle de langage performant de 70 milliards de paramètres. Avec LLaMA 4, Meta franchit un cap majeur en termes de taille, d’architecture et de fonctionnalités. Voici les principales nouveautés apportées par LLaMA 4 :

- Une architecture “Mixture of Experts” innovante : LLaMA 4 inaugure une architecture à mélange d’experts (MoE) inédite dans la gamme LLaMA. Concrètement, le modèle est composé de plusieurs sous-modèles experts (jusqu’à 128 dans LLaMA 4 Maverick) et n’active qu’une fraction de ces paramètres pour chaque requête. Cette approche permet d’accroître l’efficacité du modèle : plus de paramètres globaux, mais une utilisation sélective qui réduit le calcul inutile. Il en résulte un modèle plus rapide et efficient qu’un modèle dense classique à performance égale.

- Une capacité multimodale avancée : Grande nouveauté, LLaMA 4 est capable de traiter non seulement du texte, mais aussi des images, des vidéos et même de l’audio. Meta a conçu cette génération pour intégrer de manière fluide différents types de données. Cela signifie qu’on pourra par exemple soumettre une image ou un extrait vidéo au modèle et obtenir une analyse ou une description, là où LLaMA 2 ne comprenait que du texte. Ces capacités multimodales ouvrent la voie à des applications plus riches (assistants visuels, analyse vidéo, etc.), comblant ainsi son retard sur GPT-4 (qui proposait déjà une vision par ordinateur intégrée).

- Une fenêtre de contexte démultipliée : LLaMA 4 repousse les limites de la mémoire contextuelle. Sa version Scout offre une fenêtre de contexte pouvant aller jusqu’à 10 millions de tokens – une taille inédite dans l’industrie, équivalente à des millions de mots de contexte pouvant être pris en compte d’un seul coup. Même la version Maverick atteint un contexte d’environ 1 million de tokens, très au-dessus des 4 000 à 32 000 tokens gérés par les modèles précédents. Cette amélioration spectaculaire permet au modèle de gérer des documents volumineux, d’analyser de longues conversations ou de garder en mémoire un historique étendu. Des tâches comme la synthèse de multiples rapports ou le suivi de code sur des codebases entières deviennent envisageables en une seule requête.

- Des modèles plus grands et performants : En termes de taille brute, LLaMA 4 dépasse largement ses aînés. La variante Maverick compte 400 milliards de paramètres au total (dont 17 milliards activés par requête), soit plus de 5× le plus grand modèle LLaMA 2. Quant à Behemoth, il avoisinerait les 2 trillions (2 000 milliards) de paramètres totaux, avec 288 milliards de paramètres actifs par requête – un record absolu. Même si Behemoth reste un modèle de recherche en cours d’entraînement, son existence a permis de distiller ses connaissances vers Scout et Maverick afin de les rendre plus performants. On obtient ainsi des modèles allégés bénéficiant de la « sagesse » d’un modèle géant, une technique qui améliore sensiblement les performances à moindre coût.

- Optimisation et déploiement facilités : Meta a veillé à rendre LLaMA 4 exploitable dans divers environnements. LLaMA 4 Scout, par exemple, utilise une quantification en int4 (4 bits) pour tenir intégralement sur une carte NVIDIA H100. Cela signifie qu’une entreprise ou un laboratoire équipé d’un seul GPU haut de gamme peut faire tourner localement ce modèle bien plus puissant que LLaMA 2. De plus, dès son lancement, LLaMA 4 est proposé sur les grandes plateformes cloud (AWS Bedrock, Azure AI, Google Cloud Vertex) facilitant son intégration par les entreprises sur ces infrastructures.

Illustration : Aperçu de la famille de modèles LLaMA 4 et de leurs caractéristiques clés. Le plus grand, Behemoth, sert de modèle enseignant en pré-version, tandis que Maverick et Scout (disponibles immédiatement) offrent respectivement 1 million et 10 millions de tokens de contexte. L’architecture Mixture of Experts permet à Maverick de mobiliser 128 experts spécialisés et à Scout d’être optimisé pour l’inférence sur un seul GPU (Image: Meta).

En résumé, LLaMA 4 apporte des améliorations radicales en termes de taille de modèle, de mémoire et de polyvalence. Il comble plusieurs lacunes des anciennes versions (contexte limité, données uniquement textuelles) tout en introduisant des solutions d’ingénierie innovantes (architecture MoE) pour maintenir une efficacité élevée. Le tout, sans renier l’esprit d’ouverture qui avait fait le succès de LLaMA 2.

LLaMA 4 face à GPT-4 et aux autres modèles concurrents

Dès son annonce, Meta n’a pas hésité à comparer LLaMA 4 aux ténors existants de l’IA, affirmant que ses nouveaux modèles « écrasent la compétition ». Ces affirmations demandent bien sûr à être vérifiées de manière indépendante, mais donnent le ton sur le positionnement de LLaMA 4 dans la course aux modèles de pointe.

- Scout, le petit qui bat les autres petits : LLaMA 4 Scout est présenté comme plus performant que tous les modèles LLaMA précédents, et même supérieur aux autres compacts du marché. Meta indique que Scout surpasse ainsi Mistral 3.1 (un modèle open source concurrent de 2024) ainsi que les petites versions de Google Gemini 2.0 Flash-Lite et de son propre modèle interne Gemma 3. C’est un signal fort envoyé à la communauté open source : malgré sa relative petite taille (≈17 milliards de paramètres actifs), Scout tiendrait tête aux meilleurs modèles allégés de Google et consorts sur de nombreux tests standard.

- Maverick, l’open source qui rivalise avec GPT-4 : La version Maverick est clairement positionnée en concurrent direct de GPT-4. D’après Meta, LLaMA 4 Maverick l’emporte face à GPT-4 (version 4.0) de OpenAI et contre Gemini 2.0 Flash de Google sur plusieurs benchmarks de référence. Mieux, grâce à son architecture efficace, Maverick égalerait les performances d’un hypothétique GPT-4 géant (DeepSeek v3 dans les tests) en raisonnement et en codage, tout en n’utilisant que la moitié des paramètres actifs de ce dernier. Si ces résultats se confirment, cela signifie qu’un modèle open source parviendrait à rivaliser avec le très puissant (et fermé) GPT-4 sur des tâches complexes. C’est une première : jusqu’ici, GPT-4 restait la référence intouchable sur nombre de benchmarks, loin devant LLaMA 2 ou d’autres modèles ouverts.

- Behemoth vs GPT-4.5 et consorts : Avec Behemoth, Meta vise ni plus ni moins qu’à dépasser GPT-4.5 (la version améliorée de GPT-4 supposée en préparation chez OpenAI) ainsi que les futurs modèles de Google (Gemini 2.0 Pro) et d’Anthropic (Claude Sonnet 3.7). Sur certains domaines pointus (mathématiques – benchmark MATH-500, programmation – LiveCodeBench, Q&A scientifique – GPQA Diamond), Meta affirme que LLaMA 4 Behemoth est déjà devant ses équivalents concurrents. Étant donné sa taille colossale, on peut s’attendre à ce que Behemoth fixe de nouveaux records une fois son entraînement achevé. Néanmoins, ce modèle restera sans doute un outil de laboratoire pour Meta dans l’immédiat, plutôt qu’un système utilisable tel quel par le grand public (peu d’infrastructures disposent de la puissance nécessaire pour le faire tourner, et Meta n’envisage pas de le distribuer librement pour le moment).

Bien entendu, il convient de tempérer ces annonces très marketing. OpenAI n’a pas tardé à souligner que les évaluations « à la maison » d’un modèle ne remplacent pas des tests indépendants et que GPT-4 conserve, selon eux, une avance en termes de fiabilité et de sécurité des réponses. De son côté, Google prépare activement Gemini 3 et d’autres déclinaisons qui viendront nourrir la comparaison. Autrement dit, la course aux LLM est plus vive que jamais : chaque avancée incite les autres à redoubler d’efforts.

Il n’en demeure pas moins que LLaMA 4 marque un tournant symbolique : pour la première fois, un modèle ouvert prétend jouer dans la cour des très grands, aux côtés de GPT-4, tout en étant accessible à la communauté. Même si GPT-4 garde des atouts (une connaissance fine grâce à d’énormes volumes de données propriétaires, une optimisation poussée via les retours utilisateurs de ChatGPT, etc.), la barrière de performance entre le propriétaire et l’open source se réduit visiblement. Pour les utilisateurs finaux, cela se traduit par plus de choix et une compétition accrue gage d’amélioration continue des IA.

Impact sur le marché : open source vs solutions propriétaires

L’arrivée de LLaMA 4 renforce le débat entre IA open source et IA propriétaire sur le marché. En dotant la communauté d’un outil de niveau quasi équivalent aux meilleures offres fermées, Meta pourrait rebattre les cartes de l’écosystème IA, avec plusieurs conséquences à la clé :

- Démocratisation des IA avancées : Désormais, un laboratoire de recherche, une startup ou même une équipe indépendante peut exploiter un modèle du calibre de GPT-4 sans passer par un fournisseur tiers payant. La disponibilité de LLaMA 4 Scout (gratuitement et librement utilisable) permet à un large public d’expérimenter, d’innover et de créer des applications IA sophistiquées sans barrière à l’entrée financière. C’est un changement majeur face aux modèles propriétaires comme GPT-4, qui nécessitent un accès via API payante et restent sous le contrôle strict de leur entreprise.

- Pression sur les acteurs fermés : L’existence d’une alternative open source crédible exerce une pression concurrentielle sur OpenAI, Google et consorts. Ces derniers devront rivaliser par la qualité du service (par exemple, l’infrastructure cloud, le support, l’intégration clé en main) plutôt que par la seule supériorité technique du modèle. On pourrait aussi assister à une baisse des coûts d’utilisation des modèles propriétaires pour rester attractifs, ou à l’ajout de fonctionnalités exclusives (spécialisation, plug-ins, etc.) pour se différencier. En somme, la proposition de valeur se déplace : l’open source force les acteurs privés à en offrir davantage aux utilisateurs pour justifier leur choix.

- Équilibre entre ouverture et contrôle : Meta joue ici une carte stratégique en se posant en champion de l’open source, tout en gardant un certain contrôle. En effet, même si LLaMA 4 est qualifié d’open-source par Meta, sa licence impose des restrictions d’usage aux très grandes entreprises (plus de 700 millions d’utilisateurs) qui doivent obtenir une permission de Meta pour l’utiliser commercialement. Cette clause, déjà présente dans LLaMA 2, vise clairement les géants du web (Google, Amazon…) pour éviter qu’ils ne profitent gratuitement du fruit des recherches de Meta. L’Open Source Initiative avait d’ailleurs fait remarquer que cela empêche de considérer ces modèles comme pleinement open source au sens strict. Néanmoins, pour la majorité des acteurs du marché, la licence reste assez ouverte pour un usage libre. Meta adopte donc une approche hybride : ouverture maximale pour l’écosystème, tout en protégeant ses intérêts face aux poids lourds concurrents.

- Renforcement de l’écosystème Meta et partenaires : En diffusant LLaMA 4 largement, Meta cherche aussi à imposer ses standards. Déjà, les grands clouds (Azure de Microsoft, AWS d’Amazon, Google Cloud) proposent LLaMA 4 dans leurs catalogues de services IA. Cela signifie que de nombreuses entreprises vont l’intégrer par ce biais, renforçant son adoption. Meta y gagne en influence : si LLaMA 4 devient un pilier des solutions IA déployées partout, Meta s’affirme comme un fournisseur technologique incontournable aux côtés d’OpenAI. De plus, cette démarche alimente un cercle vertueux : plus la communauté utilise et améliore LLaMA, plus le modèle gagne en fiabilité et en fonctionnalités, au bénéfice de Meta qui peut en retour l’exploiter dans ses propres produits. Mark Zuckerberg a d’ailleurs affiché clairement l’objectif de faire de LLaMA le modèle open source de référence du marché, capable de rivaliser avec les offres propriétaires.

En définitive, LLaMA 4 pourrait rééquilibrer le rapport de force sur le marché de l’IA. Là où OpenAI et Google dominaient avec des modèles fermés surpuissants, l’essor d’un modèle ouvert de même calibre offre une alternative crédible aux entreprises et développeurs souhaitant garder la maîtrise de leurs déploiements IA. On peut y voir un parallèle avec le monde des systèmes d’exploitation : l’émergence de Linux (open source) face à Windows dans les années 2000 avait créé une saine émulation et ouvert de nouvelles opportunités. De même, l’essor de LLaMA 4 et consorts va stimuler l’innovation tout en donnant plus de contrôle aux utilisateurs sur les fondations technologiques qu’ils choisissent.

Implications pour les développeurs, chercheurs et entreprises

L’arrivée de LLaMA 4 open source dans l’écosystème n’est pas qu’une actualité de plus : c’est un événement qui influe directement sur les pratiques des développeurs, des chercheurs en IA, et des organisations qui intègrent ces technologies. Quelles opportunités et changements concrets peut-on anticiper pour ces publics ?

- Pour les développeurs : LLaMA 4 ouvre de nouvelles possibilités de projets. Un développeur peut désormais intégrer un modèle de très haut niveau dans son application sans dépendre d’une API tierce. Par exemple, une application mobile de productivité pourrait embarquer LLaMA 4 Scout en local pour offrir une assistance intelligente hors-ligne à l’utilisateur. De plus, la fine-tuning (personnalisation) de LLaMA 4 sur des données spécifiques est envisageable, ce qui permet aux développeurs de créer des IA spécialisées (santé, finance, jeu vidéo…) en se basant sur une base solide. La richesse multimodale de LLaMA 4 offre aussi aux développeurs la possibilité de concevoir des applications intégrant texte + image + audio de manière unifiée, sans combiner plusieurs modèles différents. En somme, les barrières techniques tombent : ce qui nécessitait hier des moyens colossaux (utiliser un modèle du niveau de GPT-4) devient à la portée d’une petite équipe aujourd’hui grâce à l’open source.

- Pour les chercheurs : LLaMA 4 constitue un terrain d’expérimentation rêvé. Disposer des poids d’un modèle de cette envergure permet d’étudier ses mécanismes internes, d’identifier ses biais, d’améliorer ses performances ou son efficacité énergétique, etc., chose impossible avec un modèle fermé comme GPT-4 dont on ne peut observer que les résultats. Les chercheurs en IA pourront analyser l’impact de l’architecture Mixture of Experts à grande échelle, proposer des variantes, ou explorer de nouvelles méthodes d’optimisation de la fenêtre de contexte. Par ailleurs, le fait que LLaMA 4 soit multimodal et open source facilite la recherche sur la fusion des modalités (ex : comment le modèle représente simultanément texte et image). On peut s’attendre à de nombreuses publications scientifiques s’appuyant sur LLaMA 4, qui deviendra sans doute une référence académique autant qu’un outil industriel. Enfin, la communauté de recherche pourra contribuer à améliorer le modèle (par des correctifs, des entraînements complémentaires, etc.), ce qui profite à tous de manière ouverte, contrairement aux avancées faites en vase clos sur des modèles propriétaires.

- Pour les entreprises : LLaMA 4 va sans doute accélérer l’adoption des IA génératives en entreprise. D’une part, les sociétés disposant de données sensibles ou réglementées seront rassurées de pouvoir héberger en interne un modèle performant plutôt que d’envoyer leurs données à un service cloud externe. Cela répond à des enjeux de confidentialité et de conformité (certaines industries ne pouvant utiliser des services cloud publics pour des données clients, par exemple). D’autre part, le coût d’utilisation des IA pourrait baisser : au lieu de payer à l’appel d’API ou de souscrire à un abonnement onéreux, une entreprise pourra déployer LLaMA 4 sur ses propres serveurs ou via son fournisseur cloud habituel, en gardant la main sur les coûts. De plus, la flexibilité du modèle (qui peut être affiné sur des données métiers) permettra aux entreprises de développer des solutions sur mesure : imaginez un assistant juridique entraîné spécifiquement sur toutes les jurisprudences françaises, ou un agent de support technique ayant ingurgité la documentation interne d’une société – le tout bâti sur LLaMA 4 et déployé en interne. Bien sûr, pour les très grandes entreprises (GAFA et assimilés), la licence LLaMA 4 impose une négociation avec Meta, mais nombre d’entre elles pourraient tout de même s’appuyer sur LLaMA 4 indirectement via les clouds partenaires ou en l’utilisant pour des cas d’usage internes. Enfin, l’adoption de LLaMA 4 en entreprise va encourager un écosystème de services autour de l’open source : sociétés de conseil proposant l’intégration de LLaMA 4, outils d’optimisation, de monitoring spécifiques, etc., à l’image de ce qui existe déjà autour de projets open source matures (Linux, Hadoop, etc.).

En conclusion, LLaMA 4 Open Source s’annonce comme un tournant majeur pour l’IA en 2025. En combinant la puissance d’un modèle de pointe rivalisant avec GPT-4 et la philosophie d’ouverture propre à l’open source, Meta bouscule l’équilibre établi dans le domaine de l’IA. Les dernières actualités autour de sa sortie montrent un engouement certain, tant pour ses avancées techniques (architecture MoE, multimodalité, contexte étendu) que pour ce qu’il représente dans la bataille open vs propriétaire. LLaMA 4 apporte des fonctionnalités inédites par rapport aux versions précédentes et se pose en alternative crédible face aux solutions fermées dominantes. Son impact se fera sentir à plusieurs niveaux : intensification de la concurrence pour les géants du secteur, accélération de l’innovation ouverte, et nouvelles opportunités pour développeurs, chercheurs et entreprises qui pourront s’approprier l’outil.

Meta réussit ainsi un pari audacieux : mettre à disposition de tous une technologie de pointe qui, il y a peu, n’existait qu’au sein de laboratoires fermés. Reste à observer comment la concurrence réagira – OpenAI, Google et consorts ne resteront certainement pas inactifs – mais une chose est sûre : l’ère des IA open source de haut niveau est bel et bien lancée, et LLaMA 4 en est le fer de lance.

Sources: The Verge, Turtles AI, Cybernews, Constellation Research INC,